Deepfakes superam ataques cibernéticos como principal uso malicioso de IA, aponta DeepMind

Estudo inédito da equipe liderada por Demis Hassabis descobriu que descobriu que esse tipo de falsificação representou 27% dos casos de uso criminoso de IA, aumentando temores sobre como deepfakes podem influenciar eleições globalmente neste ano

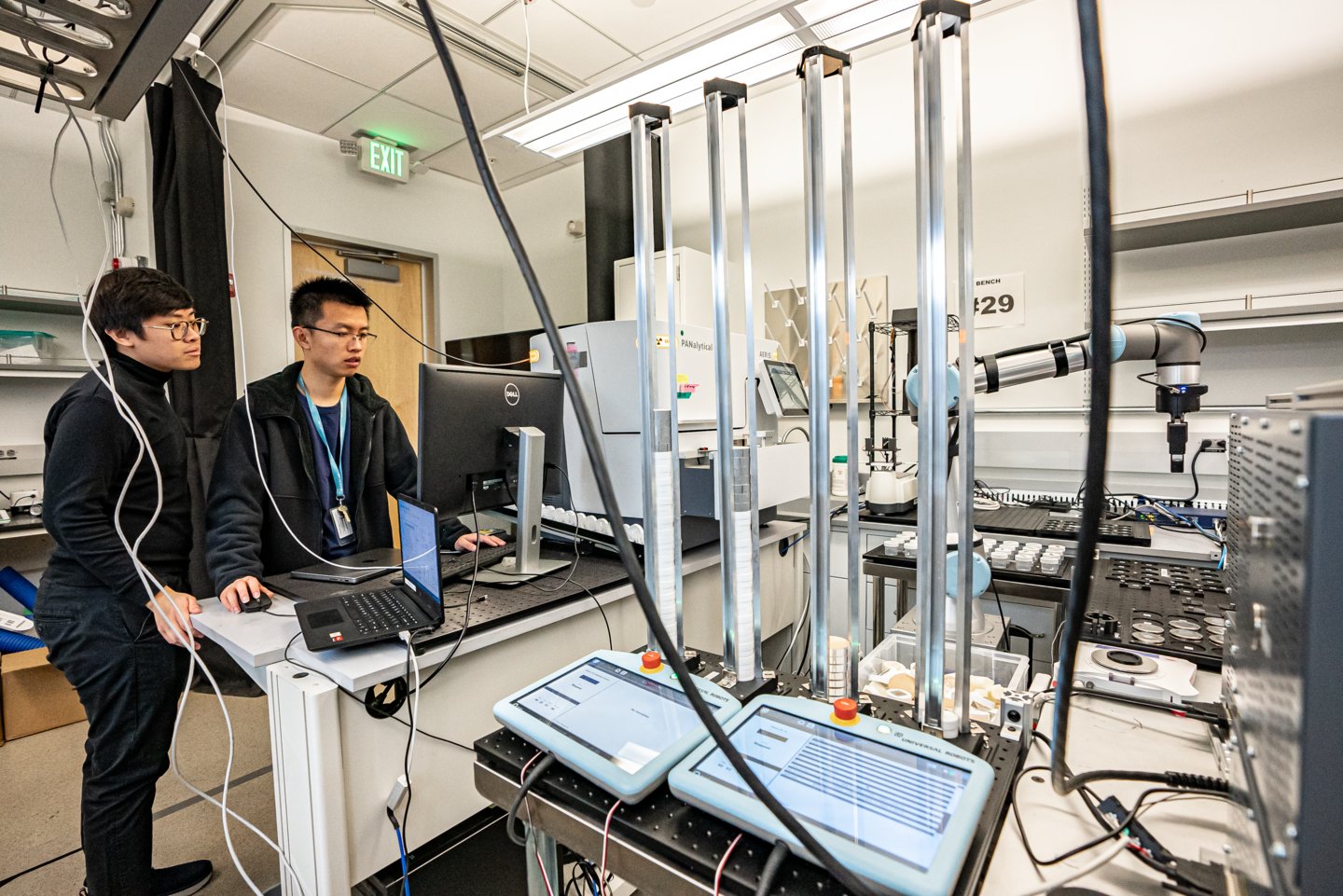

Demis Hassabis, líder do Deep Mind: a meta mais comum dos agentes que utilizam IA generativa de forma maliciosa é influenciar a opinião pública (Sarmento Matos/Getty Images)

Repórter

Publicado em 25 de junho de 2024 às 12h01.

O uso de inteligência artificial (IA) para criar deepfakes que imitam políticos e celebridades é mais prevalente do que o uso da IA para auxiliar ataques cibernéticos, conforme revela a primeira pesquisa da divisão DeepMind do Google sobre os usos maliciosos mais comuns dessa tecnologia avançada.

O estudo indica que a criação de imagens, vídeos e áudios falsos, mas realistas, de pessoas é quase duas vezes mais comum do que o segundo maior uso indevido de ferramentas de IA generativa: a falsificação de informações usando ferramentas baseadas em texto, como chatbots, para gerar desinformação online.

A meta mais comum dos agentes que utilizam IA generativa de forma maliciosa é influenciar a opinião pública. A análise, conduzida em conjunto com a unidade de pesquisa e desenvolvimento Jigsaw do Google, descobriu que esse objetivo representava 27% dos casos, aumentando os temores sobre como os deepfakes podem influenciar eleições globalmente neste ano.

Há uma preocupação generalizada de que, apesar dos esforços das plataformas de mídia social para rotular ou remover esse tipo de conteúdo, o público possa não reconhecer essas falsificações e a disseminação desse material possa influenciar os eleitores.

Este estudo é o primeiro do gênero realizado pela DeepMind, unidade de IA do Google liderada Demis Hassabis, e busca quantificar os riscos do uso de ferramentas de IA generativa, que as maiores empresas de tecnologia do mundo estão lançando para o público em busca de lucros substanciais.

À medida que produtos gerativos como o ChatGPT da OpenAI e o Gemini do Google se tornam mais amplamente utilizados, as empresas de IA estão começando a monitorar o fluxo de desinformação e outros conteúdos potencialmente prejudiciais ou antiéticos criados por suas ferramentas.

Em maio, a OpenAI divulgou uma pesquisa revelando que operações vinculadas a Rússia, China, Irã e Israel estavam usando suas ferramentas para criar e espalhar desinformação.

“Havia muita preocupação compreensível em torno de ataques cibernéticos sofisticados facilitados por essas ferramentas,” disse ao Finacial Times Nahema Marchal, autora principal do estudo e pesquisadora do Google DeepMind. “Enquanto isso, o que vimos foram usos indevidos relativamente comuns da IA generativa, como deepfakes que podem passar despercebidos com mais facilidade.”

Pesquisadores do Google DeepMind e da Jigsaw analisaram cerca de 200 incidentes de uso indevido entre janeiro de 2023 e março de 2024, coletados de plataformas de mídia social como X e Reddit, além de blogs online e relatos da mídia sobre uso indevido.

A segunda motivação mais comum para o uso indevido era gerar lucro, seja oferecendo serviços para criar deepfakes, incluindo a geração de imagens nuas de pessoas reais, ou usando IA generativa para criar grandes quantidades de conteúdo, como artigos de notícias falsas.

A pesquisa concluiu que a maioria dos incidentes utiliza ferramentas facilmente acessíveis, "requerendo mínima expertise técnica", permitindo que mais agentes mal-intencionados possam usar a IA generativa de forma indevida.

A pesquisa do Google DeepMind influenciará como a empresa melhora suas avaliações para testar a segurança dos modelos e espera-se que também afete a forma como seus concorrentes e outras partes interessadas veem a manifestação dos danos causados.

Conheça os principais laboratórios de IA do mundo

:format(webp))