Regulação da IA: como o Brasil pode se inspirar na União Europeia para regular a tecnologia no país

Brasil pode se inspirar em modelo da União Europeia, mas copiar não é o melhor caminho

(iStock/Reprodução)

Professor da Faculdade Exame

Publicado em 16 de outubro de 2024 às 18h00.

A inteligência artificial vem se consolidando como a grande inovação tecnológica do século, supostamente capaz de gerar benefícios econômicos e sociais significativos. No entanto, seu rápido avanço também traz riscos à privacidade, ao aumento das desigualdades, além da intensificação da discriminação algorítmica e violações de direitos.

Diante desses desafios, a regulamentação da IA tem se tornado prioridade, e a União Europeia (UE) emergiu como pioneira com seu Artificial Intelligence Act (AIA). A possível adoção de modelo regulatório similar pelo Brasil gera muitos questionamentos, mas, analisá-lo pode revelar lições valiosas para o nosso contexto.

Panorama evolutivo da regulação da IA na União Europeia

Como resultado da preocupação em equilibrar a proteção de direitos fundamentais com um ambiente propício para a inovação, a regulação da IA na UE evoluiu consistentemente nos últimos anos.

O marco inicial desse processo ocorreu em 2017, quando o Parlamento Europeu fez recomendações à Comissão Europeia sobre a criação de regras para robótica e IA, como bem documentado por Nikos Nikolinakos em seu livro EU Policy and Legal Framework for Artificial Intelligence, Robotics and Related Technologies - The AI Act.

Segundo Nikolinakos, em 2018, a Comissão lançou a Estratégia Europeia para a IA, abordando temas como o fomento à pesquisa, o impacto socioeconômico e a criação de um arcabouço ético e legal adequado.

Esse movimento culminou com a proposta do Artificial Intelligence Act (AIA), apresentada em 2021 e formalmente adotada em 2024, após intensos debates e consultas públicas. O AIA é o primeiro marco regulatório globalmente vinculativo (ou seja, com aplicação em todo bloco) que estabelece regras horizontais para o uso de sistemas de IA na Europa, baseando-se em uma abordagem de risco, onde sistemas de IA são classificados conforme seu impacto nos direitos e na segurança das pessoas.

Classificação de riscos dos sistemas de IA

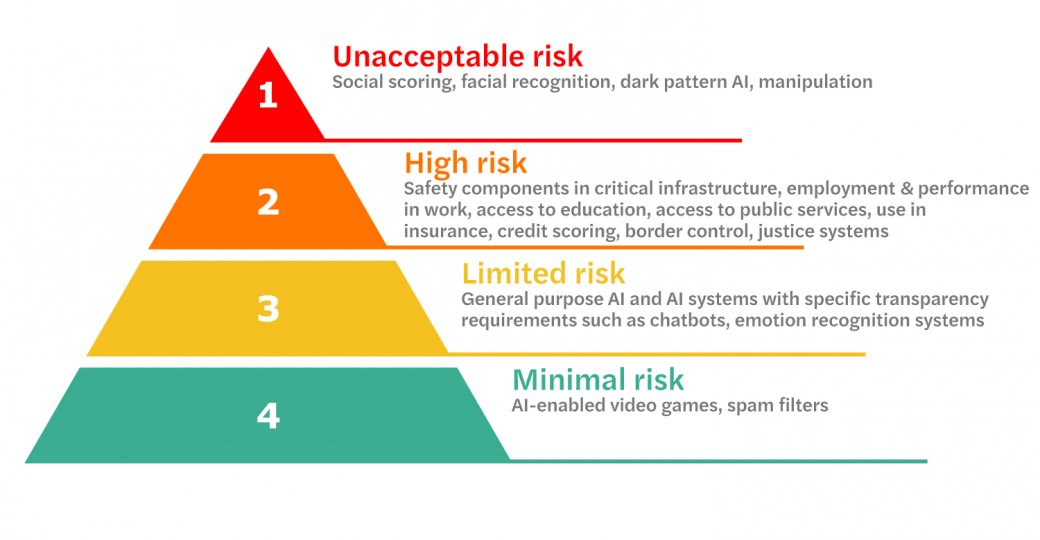

A principal inovação do AIA é a classificação dos sistemas de IA com base em seu nível de risco, sendo 4 ao todo: mínimo, limitado, alto e inaceitável.

Sistemas que apresentam riscos considerados inaceitáveis, como a manipulação subliminar ou a pontuação social (como ocorre na China), foram banidos. Já os sistemas de alto risco, que podem impactar a saúde, a segurança ou os direitos fundamentais, devem seguir requisitos rigorosos para operar (como veículos automotores operados por IA ou reconhecimento facial) incluindo garantias de transparência, supervisão humana e auditorias constantes.

Os sistemas de risco limitado, como deepfakes e chatbots, precisam priorizar a transparência, ou seja, quem vier a interagir com esses sistemas precisa saber que está interagindo com uma IA.

Por fim, os sistemas de risco mínimo, onde a vasta maioria da tecnologia se encontra, como videogames ou filtros de spam, não precisam de regulação intensa.

Essa abordagem busca equilibrar inovação e segurança, incentivando o desenvolvimento de tecnologias confiáveis, sem abrir mão da proteção aos cidadãos. O AIA estabelece, ainda, obrigações claras para desenvolvedores e operadores, como a gestão de riscos, documentação técnica detalhada e a governança de dados, garantindo que os sistemas de IA sejam rastreáveis e auditáveis.

Benefícios e limitações do modelo europeu para o Brasil

A adoção do modelo regulatório europeu pelo Brasil traria uma série de benefícios, mas, também, desafios que merecem atenção. Entre os benefícios, destaco:

- Proteção dos direitos humanos e fundamentais: assim como no contexto europeu, o Brasil possui uma estrutura constitucional que assegura direitos fundamentais, como a privacidade, a igualdade entre os cidadãos e a liberdade de expressão. A regulação europeia oferece uma base sólida para proteger esses direitos em um contexto de crescente digitalização, ponto central para evitar violações em um país tão desigual como o Brasil;

- Abordagem de risco: a categorização de riscos do AIA é especialmente útil para o Brasil, um país onde a IA já está sendo utilizada em setores críticos como saúde, segurança pública e justiça. Ao adotar essa abordagem, o Brasil pode priorizar a regulação de sistemas com maior potencial de causar danos, sem necessariamente sufocar a inovação em setores menos críticos;

- Alinhamento com padrões internacionais: a regulamentação da UE tem o potencial de se tornar um padrão global, especialmente devido ao peso econômico e político do bloco. Ao alinhar seu marco legal com o europeu, o Brasil pode facilitar sua inserção nesse mercado, reduzindo barreiras comerciais. Esse alinhamento também pode fortalecer a confiança de investidores estrangeiros nas soluções tecnológicas brasileiras.

Por outro lado, o Brasil enfrenta limitações específicas que não devem ser desconsideradas:

- Capacidade reguladora: a implementação de um marco regulatório tão abrangente quanto o AIA exige uma capacidade institucional robusta, com a criação ou adaptação de agências de fiscalização e controle com altíssima capacidade técnica. O Brasil enfrenta desafios significativos nesse campo, seja em termos de coordenação entre os diferentes níveis de governo ou no que tange à infraestrutura, tendo que lidar com mazelas sociais históricas. A experiência europeia, entretanto, oferece lições valiosas sobre como fortalecer essas capacidades, inclusive por meio de cooperação internacional;

- Adaptação ao contexto local: embora o AIA seja um modelo avançado, ele foi concebido para o contexto europeu, marcado por uma forte proteção social e uma infraestrutura tecnológica madura. No Brasil, a realidade socioeconômica é distinta, com um nível de desigualdade extremamente elevado e uma infraestrutura digital ainda em desenvolvimento. A regulação brasileira precisa ser adaptada a esse cenário, evitando a criação de barreiras desproporcionais para empresas nacionais, especialmente as pequenas e médias;

- Inovação e competitividade: embora o AIA busque promover a confiança em IA, há preocupações sobre seu impacto na inovação. Empresas menores, com menos recursos para cumprir os requisitos regulatórios, podem enfrentar dificuldades para competir. O Brasil, como um país em desenvolvimento, precisa de um marco regulatório que equilibre proteção e inovação, garantindo que startups e PMEs possam prosperar no ambiente digital.

Qual caminho seguir?

Diante dessas considerações, acredito que a adoção de um modelo regulatório semelhante ao europeu possa trazer benefícios significativos ao Brasil, especialmente em termos de proteção dos direitos humanos e de alinhamento com padrões internacionais.

Porém, vejo como imprescindível que esse modelo seja adaptado à realidade local, priorizando setores de maior risco e investindo na capacitação institucional necessária para garantir o cumprimento das regras.

O AIA oferece um modelo para enfrentar os riscos associados à IA, mas sua implementação exigirá um esforço coordenado entre governos, sociedade civil e o setor privado. Com uma abordagem equilibrada, o Brasil pode se posicionar na regulação de tecnologias emergentes, garantindo que a IA seja uma força para o bem-estar social e o desenvolvimento sustentável.

:format(webp))